Wat betekent de Europese toegankelijkheidsrichtlijn voor mijn bedrijf?

Is jouw website of webapplicatie al toegankelijk?

Is jouw website of webapplicatie al toegankelijk?

Leestijd: 4 minuten

Leestijd: 4 minuten

Geschreven door Chris Hagg

Geschreven door Chris Hagg

Benieuwd hoe wij kunnen helpen?

Regelmatig spreken wij met klanten over de mogelijkheden van AI en hoe dit kan worden toegepast binnen hun organisatie. Een veelvoorkomende vervolgvraag is dan vaak: “Maar hoe zit het met de privacy van onze data?” Dit is een terechte vraag, want de meeste AI-oplossingen zijn cloud-based en het gaat al snel om gevoelige data, zoals klantgegevens, financiële informatie of intellectueel eigendom.

Zo heeft OpenAI in hun privacy policy (https://openai.com/policies/eu-privacy-policy/) staan dat ze de data die je in hun producten invoert, kunnen gebruiken om hun modellen te verbeteren. Dit kan in theorie leiden tot situaties waarin modeltraining op basis van jouw data onbedoeld bijdraagt aan de antwoorden die andere gebruikers ontvangen. Dit is iets wat je absoluut niet wilt. Nu biedt OpenAI wel de mogelijkheid voor een opt out voor wat betreft het trainen van hun modellen met je data, maar dit is niet de standaard instelling (zakelijke accounts hebben dit standaard wel). En dan nog stuur je al je gevoelige data naar een derde partij uit Amerika.

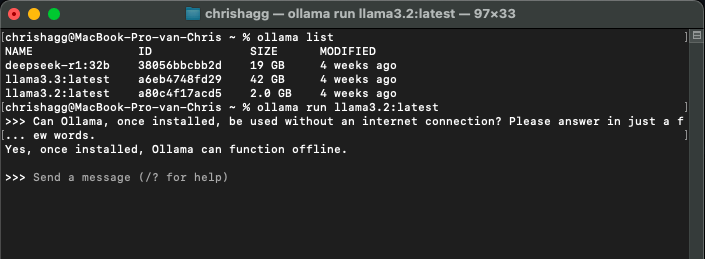

Gelukkig zijn er ook alternatieven die je de mogelijkheid bieden om AI-modellen lokaal te draaien, zonder dat je gevoelige data naar een derde partij hoeft te sturen. Een van deze alternatieven is Ollama. Dit is een platform waarmee je AI-modellen lokaal kunt draaien en gebruiken. Ollama maakt gebruik van open-source modellen zoals LLaMA, Mistral en Deepseek, die je kunt downloaden en lokaal kunt draaien (voor een complete lijst kijk je hier: https://ollama.com/search).

Dit kan zelfs op je eigen computer of server, hoe groter het model, hoe meer rekenkracht je nodig hebt om snel antwoord te krijgen. Maar hierdoor heb je volledige controle over je data en hoef je je geen zorgen te maken over privacyproblemen.

Standaard modellen zijn vaak getraind met een algemene dataset om bijvoorbeeld met je te kunnen chatten. Je kunt echter ook je eigen data gebruiken om gerichtere en relevantere antwoorden te krijgen. Dit kan op twee manieren:

Ollama biedt een REST API (compatible met die van OpenAI) waarmee je eenvoudig je eigen platform of website kunt koppelen aan de modellen. Je kunt de API gebruiken om vragen te stellen aan het model en antwoorden te ontvangen, die je vervolgens kunt verwerken in je eigen applicatie. En dit alles binnen je eigen vertrouwde infrastructuur.

Meer weten over het toepassen van AI binnen je eigen IT landschap?

Neem dan vrijblijvend contact met ons op.